1、从官网下载最新版spark

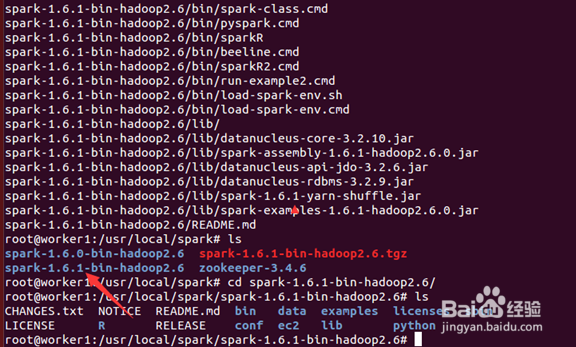

2、 将下载好的spark解压到目标文件夹中:tar –xzvf spark-1.6.1-bin-hadoop2.6.tgz。解压后spark中的内容如下所示:

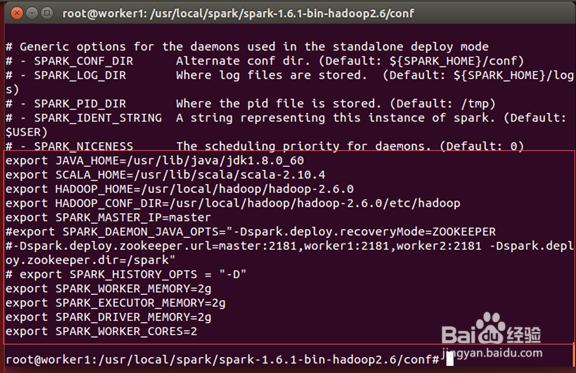

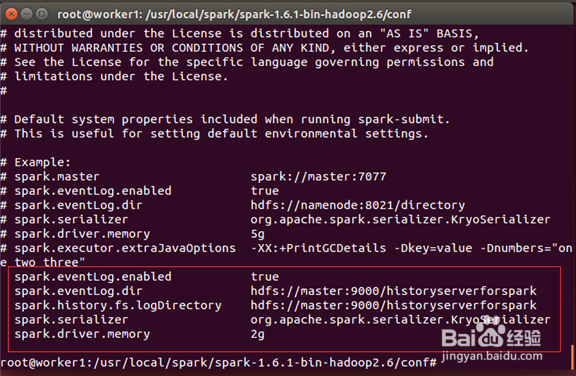

3、进入$SPARK_HOME/conf 文件夹下配置spark,主要更改的文件有slaves,spark-env.sh,spark-defaults.conf。更改后的内容如下:

Slaves:

4、Spark-env.sh:

5、Spark-defaults.conf:

6、spark官方推出新版本的时候,已经考虑了新旧版本兼容性,所以这几个配置文件的内容大体上差不多。故你也可以直接拷贝旧版本的配置文件。

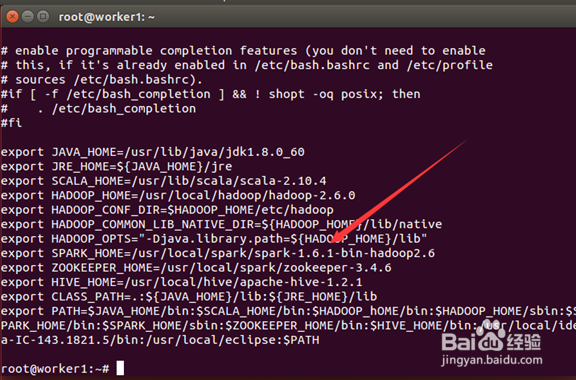

修改环境变量bashrc中的SPARK_HOME和PATH变量,指向新的版本的路径:

7、source .bashrc,使环境变量的更改生效。验证下环境变量的更改是否生效:

8、把配置好的SPARK拷贝到各个节点,并更改各个节点的 bashrc 环境变量。现在就可以使用新版本的集群啦!

9、升级到新版本后,旧的版本你也可以不删除,这样当需要的时候,你可以修改环境变量指向旧的版本,来完成回滚;当然你也可以到对应的目录下执行命令启动对应版本的集群,来测试比较新旧版本的不同。